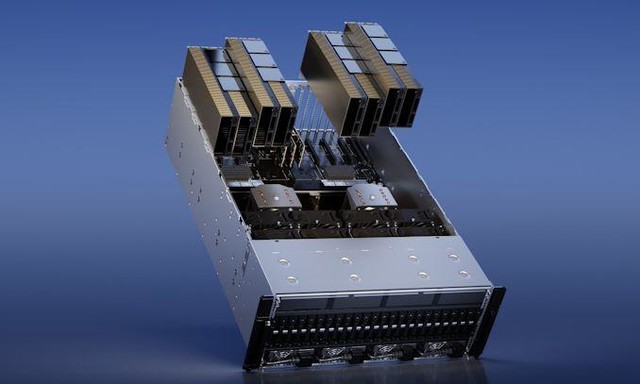

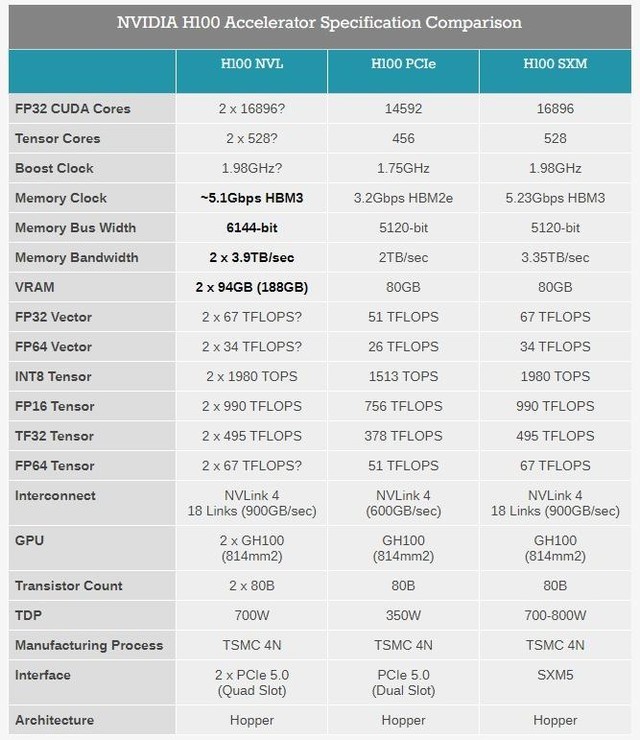

NVIDIA在GTC Spring 2023上推出了新的双GPU产品H100 NVL,以满足不断增长的AI市场需求。H100 NVL配备了3个NVLink连接器,并使用两个相邻的PCIe显卡插槽。

该产品可提供高达188GB HBM3显存,单卡显存容量达94GB,适用于运行大型语言模型(LLM)。H100 NVL的功耗略高于H100 PCIe,每个GPU为350-400瓦。总性能为FP64 134 teraflops,TF32 1979 teraflops,FP8 7916 teraflops,INT8 7916 teraops,内存带宽为每个GPU 3.9 TB/s,总和为7.8 TB/s(H100 PCIe 为2 TB/s,H100 SXM 为3.35 TB/s)。

本文属于原创文章,如若转载,请注明来源:188GB HBM3显存!英伟达针对AI市场推出双GPU H100 NVLhttps://diy.zol.com.cn/814/8144104.html