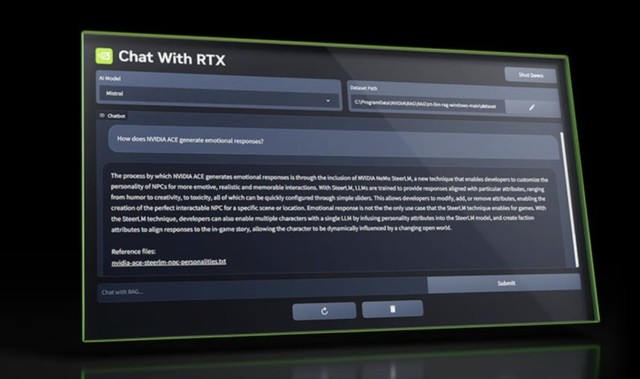

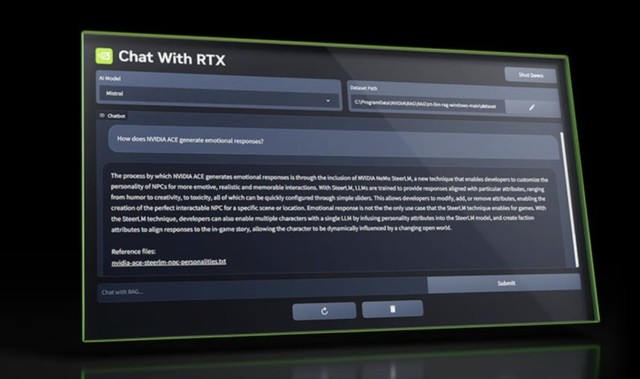

NVIDIA近日推出了Chat With RTX,这个应用相当于本地部署的ChatGPT,由GPU提供算力支持。要求的话,需要至少8GB显存的RTX 30或40系列显卡。

尽管Chat With RTX并非英伟达自己研发的大语言模型(LLM),但它背后所依靠的Mistral和Llama 2两款开源LLM却颇具实力。用户可以根据喜好自行选择使用哪款LLM。此外,Chat With RTX还支持多种文件类型,包括txt、.pdf、.doc/.docx和.xml,方便用户上传本地文件进行聊天。

值得一提的是,Chat With RTX还具有根据在线视频做回答的功能。用户只需将视频链接提供给Chat With RTX,它便能迅速根据视频内容生成答案,为用户带来全新的聊天体验。

本文属于原创文章,如若转载,请注明来源:NVIDIA推出Chat With RTX 本地部署版本ChatGPThttps://diy.zol.com.cn/855/8558515.html