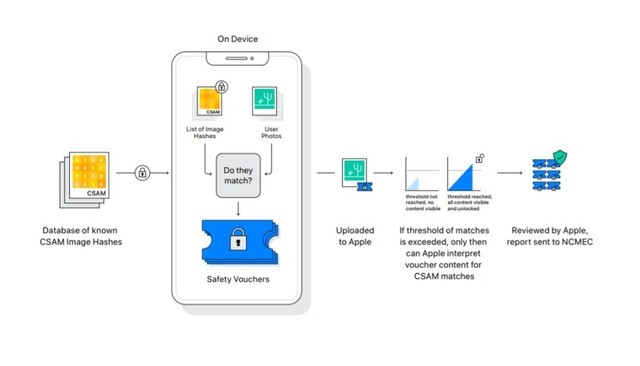

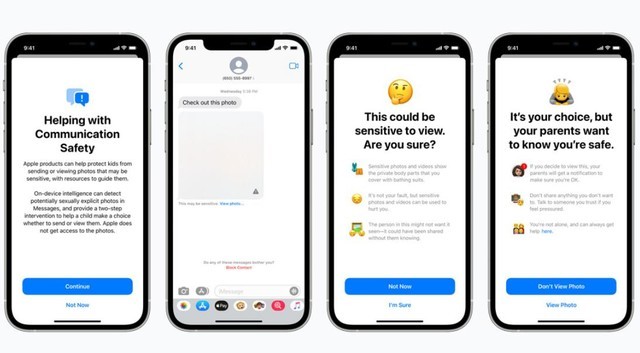

备受好评的iOS因为苹果(Apple)官网的一则新公告掀起了轩然大波:在iOS 15,iPadOS 15,watchOS 8和macOS Monterey更新后,苹果将可以分析(analyze)并在设备端匹配(on-device matching)用户的图像及信息。

苹果将可以分析你的图像和信息了

和此前苹果拒绝为FBI解锁手机而遭到起诉相反,CSAM 检测将帮助苹果向执法部门提供有关 iCloud 照片中 CSAM 集合的宝贵信息。(CSAM detection will help Apple provide valuable information to law enforcement on collections of CSAM in iCloud Photos.)

虽然这项检测在名义上是正义的,但是未经用户许可的做法却充满了争议,这到底是为了社会进步,还是为了苹果公司的私利?抑或是有其他目的呢?

我们关注的重点不在于图像的识别技术是否准确,不在于无法判断的图片是否会交由人工审核,重点在于:苹果将可以扫描你设备上的所有内容了。

01 我的数据谁做主?

不管是iPhone还是ipad,苹果公司出售的都是个人设备,用户不仅拥有设备的所有权和使用权,还应拥有对数据的管理权,这就包括了谁能看,谁不能看。

苹果未经允许,直接扫描所有用户的所有图片和信息,这就是直接把所有用户当做了潜在的嫌犯,苹果一直在标榜自己重视保护用户隐私,但扫描数据的做法和隐私保护是背道而驰的。

02 我的性能谁支配?

还有一个问题,iOS的设备端匹配是占用本地资源的,也就是会占用硬件性能和电量,在进行比对时还要占用网络带宽,而这一部分资源都是用户承担的,这样做同样不合适。

操作系统的任何一项功能,不管有多么节能,不管有多么智能,即使其先进到不会犯错,用户也应该拥有其管理权,是否运行应该由用户说了算,而不是静默运行,全面扫描。更何况苹果这项技术不可能不犯错:苹果会人工审核每份报告(Apple then manually reviews each report)。

03 我的隐私谁守护?

尽管苹果保证不将数据用作任何其他用途,但作为一个以营利为目的的公司,苹果的保证并不能让所有用户放心。

NeuralHash 神经网络不公开算法,我们其实并没有办法知道苹果是否真的如其所说只进行了CSAM 检测,苹果利用这个算法进行其他识别我们也是不得而知的。

iOS 15未经用户允许增加了儿童色情内容识别,谁能保证iOS 16不会增加暴力内容识别,iOS 17上不会增加脏话内容识别呢?今天苹果开了这个先例,明天谷歌会不会跟进,后天三星会不会也上线类似功能呢?

虽然这项技术目前对中国区用户没有影响,但涉及到用户隐私,我不能容忍苹果在iOS中加入CSAM 检测,更不能容忍苹果在未经我允许的前提下扫描我的照片,读取我的信息,干涉我的搜索。执法机构审查手机内容好歹还需要搜查证,苹果直接跳过这一步把所有人当做潜在嫌犯?苹果,可真有你的!

本文属于原创文章,如若转载,请注明来源:用户隐私算老几?该容忍苹果检测你的照片吗https://diy.zol.com.cn/775/7753067.html